当语言模型(假定包括ChatGPT)转述和重用训练数据中的概念而不引用原始来源时,就会引起抄袭的担忧。

在用聊天机器人完成他们的下一个作业之前,学生们可能需要考虑一下。宾夕法尼亚大学(Penn University)领导的一个研究小组进行了第一个专门针对这一主题的研究,他们发现,根据用户提示生成文本的语言模型以多种方式抄袭内容。

宾夕法尼亚州立大学信息科学与技术教授李东源(Dongwon Lee)说:“抄袭有不同的形式。“我们想看看语言模型是否不仅复制粘贴,还会在没有意识到的情况下采用更复杂的抄袭形式。”

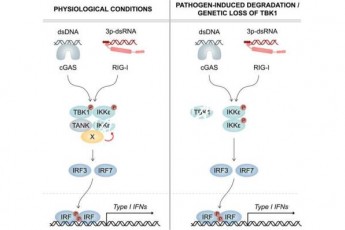

研究人员重点识别了三种形式的抄袭:逐字复制或直接复制和粘贴内容;在不引用原文的情况下,对内容进行改写、改写和重组;还有idea,或者从文章中使用主要观点,而没有适当的归属。他们构建了一个用于自动抄袭检测的管道,并将其与OpenAI的GPT-2进行了测试,因为该语言模型的训练数据可以在线获得,允许研究人员将生成的文本与用于预训练GPT-2的800万份文档进行比较。

科学家们使用了21万篇生成的文本来测试预先训练过的语言模型和微调过的语言模型中是否存在抄袭,或者是进一步训练以专注于特定主题领域的模型。在这种情况下,该团队对三种语言模型进行了微调,以专注于科学文件、与COVID-19相关的学术文章和专利要求。他们使用开源搜索引擎检索了与每个生成文本最相似的前10个培训文档,并修改了现有的文本对齐算法,以更好地检测逐字逐句、转述和抄袭思想的实例。

研究小组发现,语言模型存在所有三种类型的抄袭,用于训练模型的数据集和参数越大,抄袭发生的频率就越高。他们还指出,经过微调的语言模型减少了逐字抄袭,但增加了转述和抄袭思想的情况。此外,他们还发现了语言模型通过所有三种形式的抄袭暴露个人隐私信息的实例。研究人员将在4月30日至5月4日在德克萨斯州奥斯汀举行的2023年ACM Web会议上展示他们的发现。

“人们追求大型语言模型,因为模型越大,生成能力就越强,”主要作者、宾夕法尼亚州立大学信息科学与技术学院的博士生Jooyoung Lee说。“与此同时,他们正在危害训练语料库中内容的原创性和创造性。这是一个重要的发现。”

据研究人员称,这项研究强调了对文本生成器及其提出的伦理和哲学问题进行更多研究的必要性。

密西西比大学(University of Mississippi)计算机与信息科学助理教授泰乐(Thai Le)说:“尽管输出结果可能很吸引人,语言模型使用起来可能很有趣,对某些任务似乎很有成效,但这并不意味着它们是实用的。”泰乐在宾夕法尼亚州立大学(Penn State)攻读博士学位时就开始参与这个项目。“在实践中,我们需要注意文本生成器带来的道德和版权问题。”

虽然这项研究的结果只适用于GPT-2,但研究人员建立的自动抄袭检测过程可以应用于更新的语言模型,如ChatGPT,以确定这些模型是否抄袭训练内容,以及抄袭的频率。然而,研究人员表示,测试抄袭与否取决于开发人员是否将培训数据公开。

科学家们表示,目前的研究可以帮助人工智能研究人员在未来建立更健壮、更可靠、反应更灵敏的语言模型。目前,他们敦促个人在使用文本生成器时要谨慎。

宾夕法尼亚州立大学信息科学与技术助理教授陈景辉表示:“人工智能研究人员和科学家正在研究如何使语言模型更好、更健壮,与此同时,许多人在日常生活中使用语言模型来完成各种生产力任务。”“虽然利用语言模型作为搜索引擎或堆栈溢出来调试代码可能没问题,但出于其他目的,因为语言模型可能会产生抄袭的内容,这可能会给用户带来负面后果。”

李东源补充说:“抄袭的结果并不出乎意料。

他说:“就像一只随机鹦鹉,我们教语言模型模仿人类的作品,却没有教它们如何不正确地抄袭。”“现在,是时候教他们更正确地写作了,我们还有很长的路要走。”

o nePlus 11 5G在该公司的Cloud 11发布会上发布,该公司还推出了其他几款设备。我们将在gadget 360播客轨道上讨论这款新手机和一加的所有新硬件。轨道可以在Spotify,加纳,JioSaavn,谷歌播客,苹果播客,亚马逊音乐和其他地方使用 只要你有播客。