罗利——研究人员开发了一项新的实验,以更好地了解人们认为与驾驶汽车有关的道德和不道德的决定,目的是收集数据,训练自动驾驶汽车如何做出“好的”决定。这幅作品的目的是捕捉交通中一系列更为现实的道德挑战,而不是被广泛讨论的由所谓的“电车问题”启发的生死场景。

北卡罗莱纳州立大学博士后达里奥·切奇尼(Dario Cecchini)是该研究论文的第一作者,他说:“电车问题提出了一种情况,即某人必须决定是否故意杀死一个人(这违反了道德规范),以避免多人死亡。”

“近年来,电车问题被用作研究交通道德判断的范例,”切奇尼说。“对于自动驾驶汽车来说,典型的情况包括两种选择:向左转弯,撞上致命的障碍物;或者向前行驶,撞上过马路的行人。然而,这些类似电车的案例是不现实的。司机们每天都要做出许多更现实的道德决定。我应该超速驾驶吗?我应该闯红灯吗?我应该靠边停车等救护车吗?”

“这些平凡的决定很重要,因为它们最终会导致生死攸关的情况,”该论文的通讯作者、北卡罗来纳州立大学科学、技术与社会项目副教授Veljko dubljeviki说。

“例如,如果有人超速行驶20英里并闯红灯,那么他们可能会发现自己处于一种不得不转向车流或发生碰撞的境地。目前,关于我们如何对司机在日常情况下做出的决定做出道德判断的文献数据很少。”

为了解决数据缺乏的问题,研究人员开发了一系列实验,旨在收集有关人类如何对人们在低风险交通情况下做出的决定做出道德判断的数据。研究人员创造了七种不同的驾驶场景,比如父母在试图让孩子按时上学的同时,必须决定是否违反交通信号灯。每个场景都被编程到虚拟现实环境中,因此参与实验的研究参与者可以获得驾驶员在做决定时的视听信息,而不是简单地阅读场景。

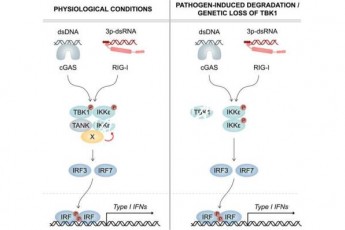

在这项工作中,研究人员建立了一种称为代理行为后果(ADC)的模型,该模型假设人们在做出道德判断时要考虑三件事:代理,即做某事的人的性格或意图;行为或正在做的事;以及行为产生的后果或结果。

研究人员创造了每个交通场景的八个不同版本,改变了代理人、行为和后果的组合。例如,在一个版本的场景中,父母试图送孩子去学校,父母很关心,在黄灯前刹车,让孩子准时到达学校。在第二个版本中,父母谩骂,闯红灯,造成事故。其他六个版本改变了父母(代理)的性质,他们在交通信号时的决定(契约),和/或他们决定的结果(后果)。

切奇尼说:“我们的目标是让研究参与者看到每个场景的一个版本,并在从1到10的范围内确定司机在每个场景中的行为道德程度。”“这将为我们提供可靠的数据,让我们了解在驾驶车辆时我们认为的道德行为,然后这些数据可用于开发用于自动驾驶车辆道德决策的人工智能算法。”

研究人员已经进行了试点测试,以微调场景,确保它们反映出可信且易于理解的情况。

“下一步是进行大规模的数据收集,让成千上万的人参与实验,”dubljeviki说。“然后,我们可以利用这些数据开发更多的互动实验,目的是进一步微调我们对道德决策的理解。”所有这些都可以用来创建用于自动驾驶汽车的算法。然后,我们需要进行额外的测试,看看这些算法的表现如何。”

这篇题为“现实交通场景中的道德判断:超越电车范式的自动驾驶汽车伦理”的论文发表在《人工智能与社会:知识、文化与交流》杂志上。该论文由北卡罗来纳州立大学研究生肖恩·布兰特利(Sean Brantley)共同撰写。这项工作得到了美国国家科学基金会的支持,资助号为2043612。